从一句话生成一张图,到几秒钟生成一段视频,生成式人工智能正在走向更复杂的真实世界应用。然而,模型越大、分辨率越高、生成内容越丰富,对算力与能耗的需求就越惊人。在后摩尔定律时代,面向未来的科研焦点转向光电计算等“下一代算力芯片”。

19日,解放日报·上观新闻记者从上海交通大学获悉,交大集成电路学院陈一彤课题组在新一代算力芯片方向取得重大突破,首次实现了支持大规模语义视觉生成模型的全光计算芯片LightGen。

相关研究以《大规模智能语义视觉生成全光芯片》(All-optical synthesis chip for large-scale intelligent semantic vision generation)发表于国际顶级学术期刊《科学》(Science)上。

同步被Science官方选为高光论文重点报道。

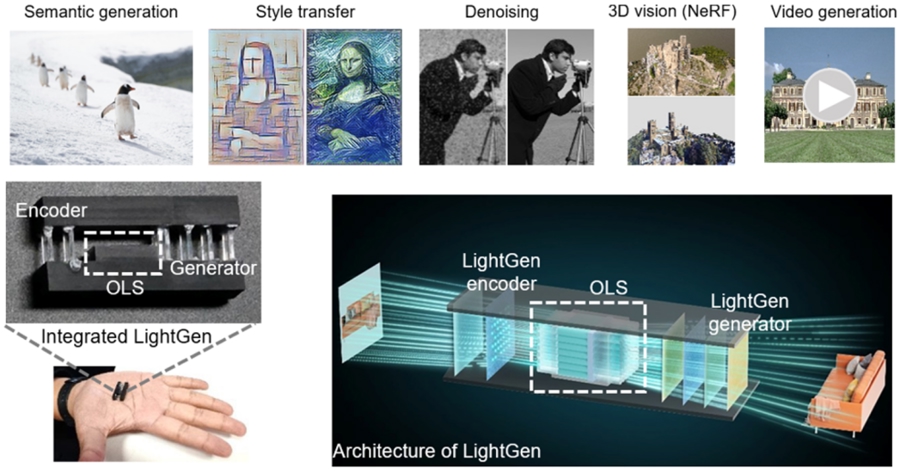

当前,光电芯片仍主要擅长加速判别类的任务,距离支撑前沿大规模生成模型还有不小距离。因此,“如何让下一代算力光芯片能够运行复杂生成模型”,成为全球智能计算领域公认的难题。

所谓“光计算”,可以通俗理解为:不是让电子在晶体管中运行,而是让光在芯片中传播,用光场的变化完成计算。由于光天然具备高速和并行的优势,长期被视为突破算力与能耗瓶颈的重要方向。

不过,要把光计算真正用到生成式AI上,并非这么简单:生成模型往往规模更大,还需要在不同维度之间不断变换;而如果芯片规模较小,则不得不频繁在光与电之间级联或复用,速度优势就会被延迟与能耗迅速抵消。因此,全光计算,就显得更为重要,同时也更为困难。

大规模全光生成计算芯片LightGen

LightGen芯片之所以能够实现惊人的性能飞跃,在于它在单枚芯片上同时突破了三项领域公认的关键瓶颈:单片上百万级光学神经元集成、全光维度转换,不依赖真值的光学生成模型训练算法。这三项中的任意一项单独突破都足以构成重要进展,而LightGen同时做到,使得面向大规模生成任务的全光端到端实现成为可能。

更重要的是,LightGen芯片展现的并不是“电辅助光”做生成,而是让全光芯片完整实现“输入—理解—语义操控—生成”的闭环:输入图像进入芯片后,系统能够提取与表征语义信息,并在语义操控下生成全新的媒体数据,实现让光“理解”和“认知”语义。

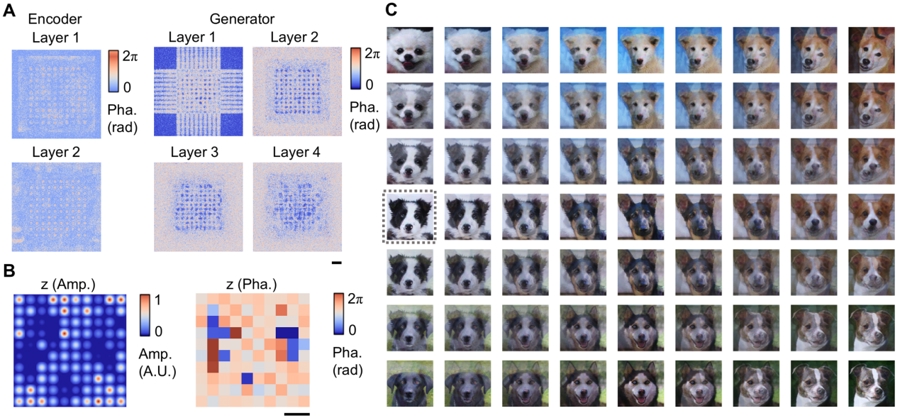

经新论文的实验验证,LightGen可完成高分辨率(≥512×512)图像语义生成、3D生成(NeRF)、高清视频生成及语义调控,同时支持去噪、局部与全局特征迁移等多项大规模生成式任务。

LightGen生成的采样图像示例

在性能评估上,LightGen芯片采用了极严格的算力评价标准:在与电芯片上运行的多个前沿电子神经网络相仿生成质量的前提下,直接对端到端耗时与耗能进行测量。实测表明,即便采用较滞后性能的输入设备,LightGen芯片仍可取得相比顶尖数字芯片2个数量级的算力和能效提升。

而如果采用前沿设备使得信号输入频率不作为瓶颈的情况下,LightGen芯片理论可实现算力提升7个数量级、能效提升8个数量级的性能跃升。这不仅体现了在不牺牲生成效果的情况下,用全光方案替换现有方案可能带来的巨大增益,也从侧面印证了大规模集成、全光维度变换与无真值训练等难点被系统性解决后,在全光片上承载大规模生成网络的现实意义。

这项重要成果同步被Science官方选为高光论文重点报道。文中提到,生成式AI正加速融入生产生活,要让“下一代算力芯片”在现代人工智能社会中真正实用,势在必行的是研发能够直接执行真实世界所需前沿任务的芯片——尤其是大规模生成模型这类对端到端时延与能耗极高的任务。面向这一目标,LightGen为新一代算力芯片真正助力前沿人工智能开辟了新路径,也为探索更高速、更高能效的生成式智能计算提供了新的研究方向。

(文章来源:上观新闻)